Pesquisadores descobriram que modelos populares de criação de imagens são suscetíveis a serem instruídos a gerar imagens reconhecíveis de pessoas reais, potencialmente colocando em risco sua privacidade. Alguns prompts fazem com que a IA copie uma imagem em vez de desenvolver algo totalmente diferente. Essas imagens refeitas podem conter material protegido por direitos autorais. Mas o pior é que os modelos geradores de IA contemporâneos podem memorizar e replicar dados privados coletados para uso em um conjunto de treinamento de IA.

O Problema encontrado nas imagens geradas por IA

Os pesquisadores reuniram mais de mil exemplos de treinamento dos modelos, que variavam de fotografias de pessoas individuais a fotos de filmes, imagens de notícias com direitos autorais e logotipos de empresas com marca registrada, e descobriram que a IA reproduzia muitos deles de maneira quase idêntica.

Pesquisadores de faculdades como Princeton e Berkeley, bem como do setor de tecnologia – especificamente Google e DeepMind – conduziram o estudo.

A mesma equipe trabalhou em um estudo anterior que apontou um problema semelhante com modelos de linguagem AI, especialmente GPT2, o precursor do ChatGPT de grande sucesso da OpenAI.

Reunindo a banda, a equipe sob a orientação do pesquisador do Google Brain, Nicholas Carlini, descobriu os resultados fornecendo legendas para imagens, como o nome de uma pessoa, para o Imagen and Stable Diffusion do Google.

Em seguida, verificaram se alguma das imagens geradas correspondia aos originais mantidos no banco de dados do modelo.

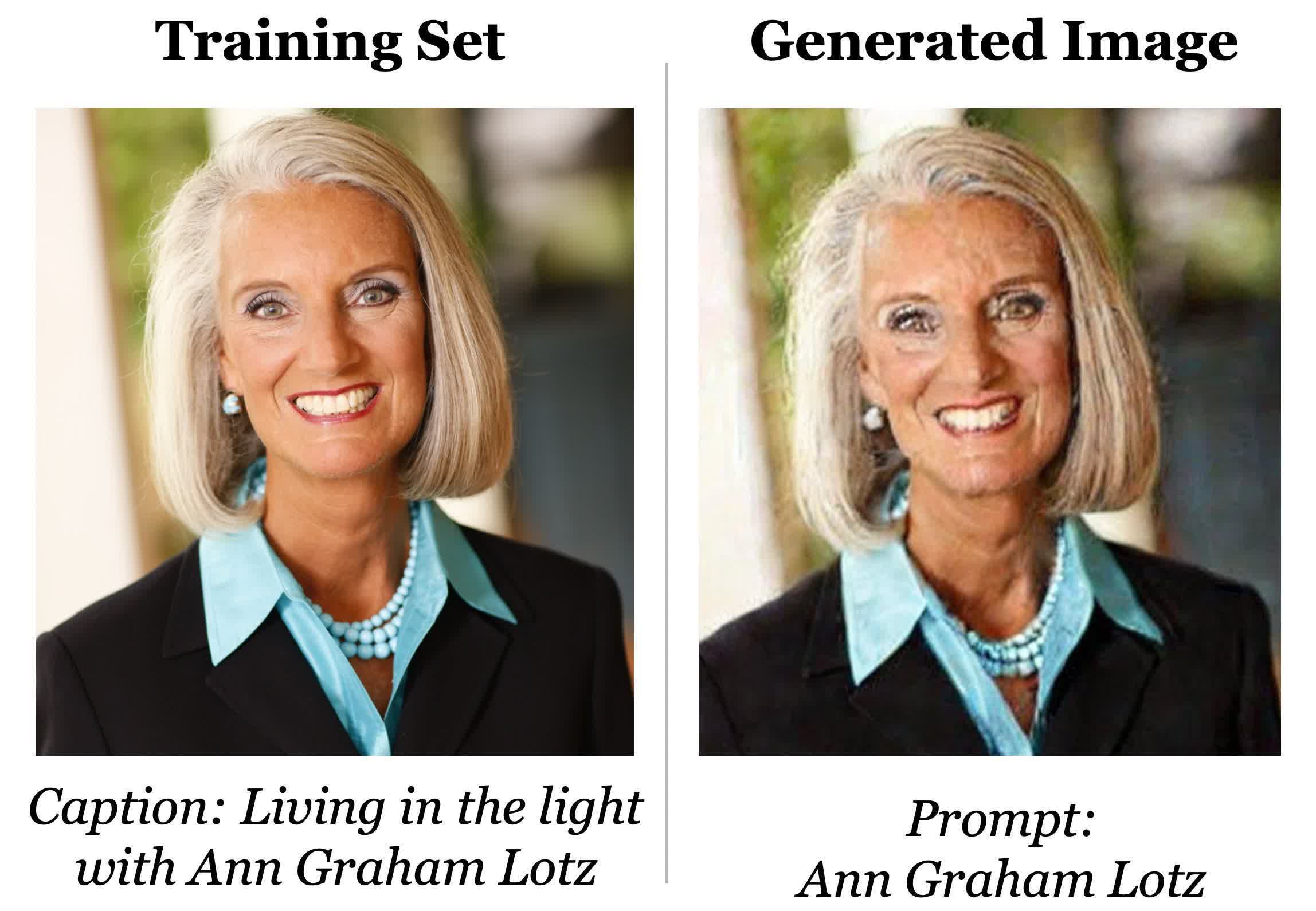

O conjunto de dados do Stable Diffusion, a coleção de imagens raspadas de vários terabytes conhecida como LAION, foi usado para gerar a imagem abaixo. Ele usou a legenda especificada no conjunto de dados.

A imagem idêntica, embora ligeiramente distorcida pelo ruído digital, foi produzida quando os pesquisadores inseriram a legenda no prompt de difusão estável. Em seguida, a equipe verificou manualmente se a imagem fazia parte do conjunto de treinamento após executar repetidamente o mesmo prompt.

Os pesquisadores observaram que uma resposta não memorizada ainda pode representar fielmente o texto com o qual o modelo foi solicitado, mas não teria a mesma composição de pixels e seria diferente de qualquer imagem de treinamento.

O professor de ciência da computação na ETH Zurich e o participante da pesquisa Florian Tramèr observaram limitações significativas nas descobertas. As fotos que os pesquisadores conseguiram extrair ou se repetiram com frequência nos dados de treinamento ou se destacaram significativamente do restante das fotos no conjunto de dados.

De acordo com Florian Tramèr, aqueles com nomes ou aparências incomuns são mais propensos a serem ‘memorizados’.

Os modelos de IA de difusão são o tipo menos privado de modelo de geração de imagens, conforme os pesquisadores.

Em comparação com as Generative Adversarial Networks (GANs), uma classe anterior de modelo de imagem, elas vazam mais que o dobro dos dados de treinamento.

O objetivo da pesquisa é alertar os desenvolvedores sobre os riscos de privacidade associados aos modelos de difusão, que incluem uma variedade de preocupações, como o potencial de uso indevido e duplicação de dados privados confidenciais protegidos por direitos autorais, incluindo imagens médicas e vulnerabilidade a ataques externos onde o treinamento os dados podem ser facilmente extraídos.

Uma correção que os pesquisadores sugerem é identificar imagens duplicadas geradas por IA no conjunto de treinamento e removê-las da coleta de dados.

Leia também: Microsoft cria supercomputador para inteligencia Artificial com 285.000 núcleos